NVIDIA H200 数据表

NVIDIA H200 Tensor Core GPU 全球最强大的GPU,用于增强AI和高性能计算(HPC)工作负载。

更高的性能和更大、更快的内存 NVIDIA H200 Tensor Core GPU通过革命性的性能和内存能力增强了生成性AI和高性能计算(HPC)工作负载。

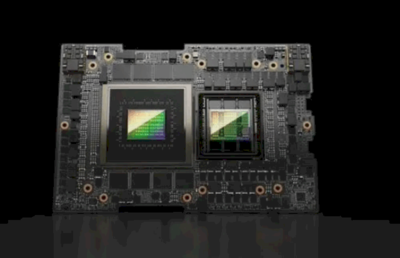

基于NVIDIA Hopper™架构,NVIDIA H200是首个提供141GB HBM3e内存、带有4.8 TB/s带宽的GPU——这是NVIDIA H100 Tensor Core GPU内存容量的几乎两倍,内存带宽提高了1.4倍。H200的更大、更快的内存加速了生成性AI和大语言模型,同时在科学计算和HPC工作负载中实现了更好的能源效率和更低的总拥有成本。

高性能大语言模型(LLM)推理 在AI不断发展的背景下,企业依赖大语言模型来满足各种推理需求。当大规模部署以服务庞大的用户群时,AI推理加速器必须以最低的总拥有成本提供最高的吞吐量。H200在处理如Llama2 70B等大语言模型时,推理性能比H100 GPU提高了一倍。

主要特性:

- 141GB HBM3e GPU内存

- 4.8TB/s的内存带宽

- 4 petaFLOPS的FP8性能

- 2倍的LLM推理性能

- 110倍的HPC性能

加速高性能计算 内存带宽对HPC应用至关重要,因为它能加快数据传输并减少复杂处理的瓶颈。对于内存密集型的HPC应用,如仿真、科学研究和人工智能,H200更高的内存带宽确保数据可以高效地访问和操作,从而实现110倍的结果时间加速。

减少能源和总拥有成本 随着H200的推出,能源效率和总拥有成本达到了新的高度。这一尖端技术在与H100 Tensor Core GPU相同的功耗范围内提供了无与伦比的性能。更快且更环保的AI工厂和超算系统为AI和科学界带来了经济优势。

准备好开始了吗? 要了解更多关于NVIDIA H200 Tensor Core GPU的信息,请访问 nvidia.com/h200

技术规格

- 形态:H200 SXM1

- FP64:34 TFLOPS

- FP64 Tensor Core:67 TFLOPS

- FP32:67 TFLOPS

- TF32 Tensor Core:989 TFLOPS

- BFLOAT16 Tensor Core:1,979 TFLOPS

- FP16 Tensor Core:1,979 TFLOPS

- FP8 Tensor Core:3,958 TFLOPS

- INT8 Tensor Core:3,958 TFLOPS

- GPU内存:141GB

- GPU内存带宽:4.8TB/s

- 解码器:7 NVDEC,7 JPEG

- 最大热设计功耗(TDP):可配置至700W

- 多实例GPU:最多7个MIG,每个16.5GB

- 形态:SXM

- 互连:NVIDIA NVLink:> 900GB/s,PCIe Gen5:128GB/s

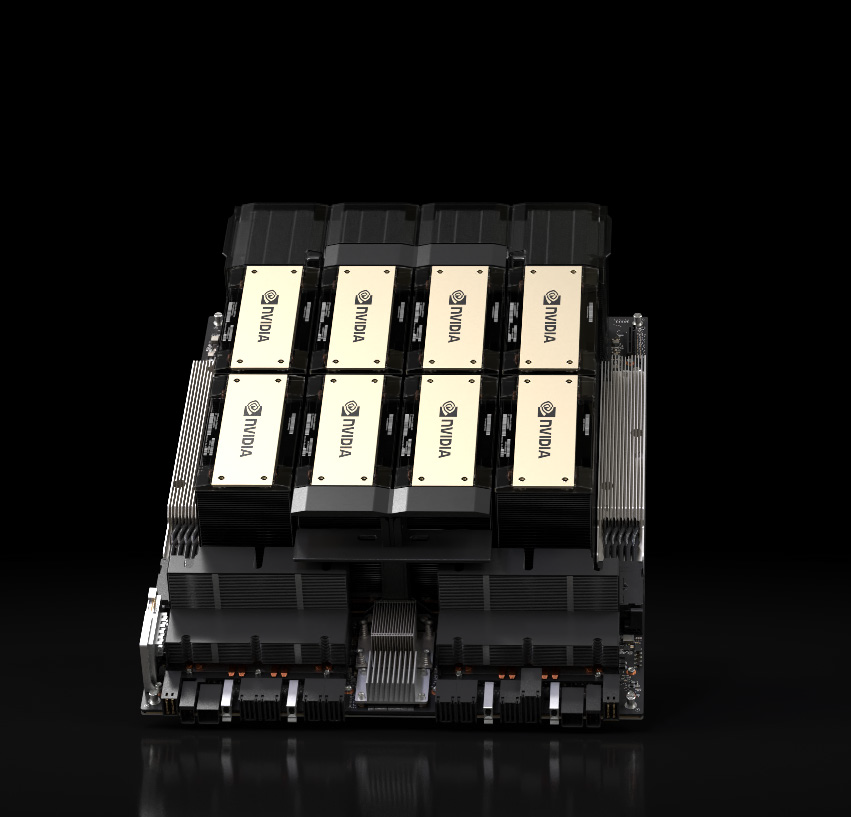

- 服务器选项:NVIDIA HGX™ H200合作伙伴和NVIDIA认证系统,配备4或8个GPU

- NVIDIA AI Enterprise附加组件

*初步规格,可能会有所变化。