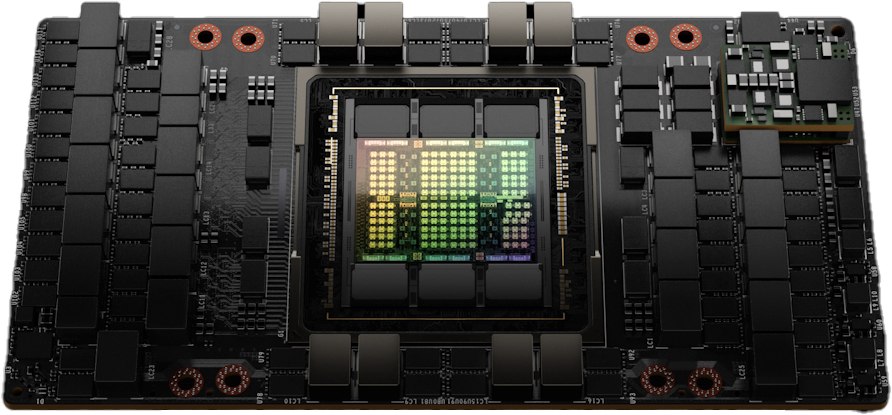

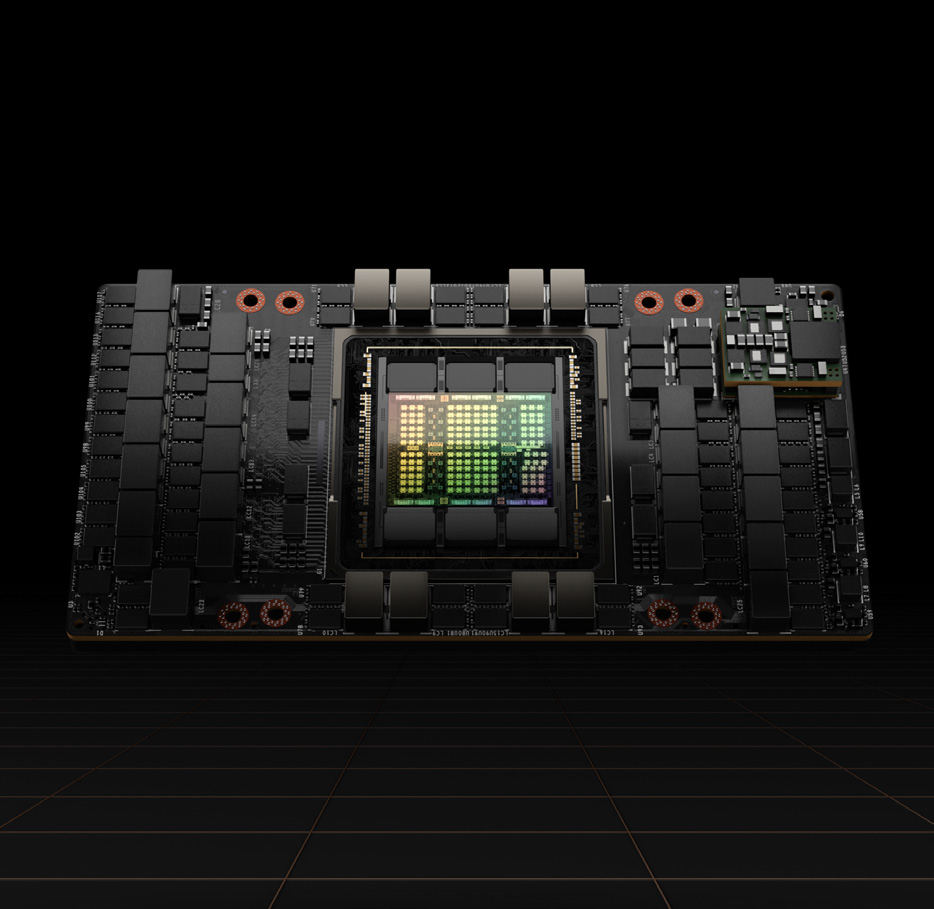

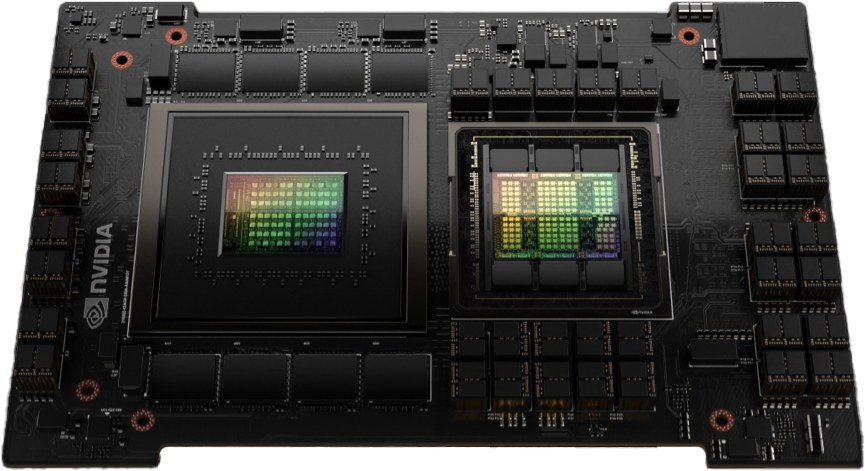

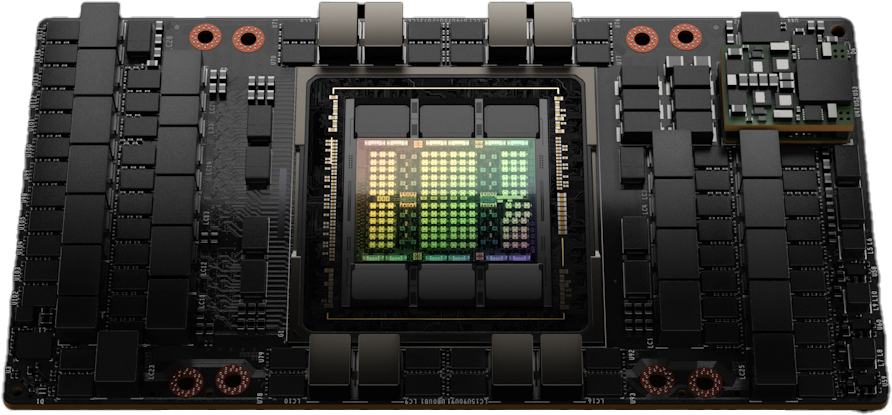

NVIDIA H100 Tensor Core GPU

卓越的性能、可扩展性和安全性,适用于每个数据中心。

在加速计算中实现数量级的飞跃

NVIDIA H100 Tensor Core GPU 为每个工作负载提供卓越的性能、可扩展性和安全性。通过 NVIDIA® NVLink® 交换系统,可以连接多达 256 个 H100 GPU 来加速百亿亿次运算的工作负载,同时专用的 Transformer 引擎支持万亿参数的语言模型。H100 使用 NVIDIA Hopper™ 架构中的突破性创新技术,在行业领先的会话式 AI 中,将大规模语言模型的速度提高了 30 倍。

准备好迎接企业 AI 吗?

NVIDIA H100 GPU 为主流服务器提供五年软件订阅,包括企业支持,以简化 AI 的采用,并提供最高性能。这确保了组织能够访问构建 H100 加速的 AI 工作流程所需的 AI 框架和工具,例如 AI 聊天机器人、推荐引擎、视觉 AI 等。访问 NVIDIA AI 企业软件订阅和相关支持福利。

从企业到百亿亿次运算,安全加速工作负载

NVIDIA H100 GPU 具有第四代 Tensor Core 和 FP8 精度的 Transformer 引擎,通过 9 倍更快的训练速度和在大型语言模型上高达 30 倍的推理速度,进一步扩展了 NVIDIA 在 AI 领域的市场领先地位。对于高性能计算 (HPC) 应用,H100 将 FP64 的浮点运算每秒次数 (FLOPS) 提高了 3 倍,并增加了动态编程 (DPX) 指令,提供高达 7 倍的性能提升。通过第二代多实例 GPU (MIG)、内置的 NVIDIA 机密计算和 NVIDIA NVLink 交换系统,H100 为从企业到百亿亿次运算的每个数据中心安全加速所有工作负载。

加速每个工作负载,无处不在

NVIDIA H100 是 NVIDIA 数据中心平台的重要组成部分。该平台为 AI、HPC 和数据分析而构建,加速了超过 3000 个应用程序,并在从数据中心到边缘的每个地方提供戏剧性的性能提升和成本节省机会.

技术规格:

|

指标 |

H100 SXM |

H100 PCIe |

H100 NVL1 |

|

FP64 |

34 teraFLOPS |

26 teraFLOPS |

68 teraFLOPS |

|

FP64 Tensor Core |

67 teraFLOPS |

51 teraFLOPS |

134 teraFLOPS |

|

FP32 |

67 teraFLOPS |

51 teraFLOPS |

134 teraFLOPS |

|

TF32 Tensor Core |

989 teraFLOPS2 |

756 teraFLOPS2 |

1,979 teraFLOPS2 |

|

BFLOAT16 Tensor Core |

1,979 teraFLOPS2 |

1,513 teraFLOPS2 |

3,958 teraFLOPS2 |

|

FP16 Tensor Core |

1,979 teraFLOPS2 |

1,513 teraFLOPS2 |

3,958 teraFLOPS2 |

|

FP8 Tensor Core |

3,958 teraFLOPS2 |

3,026 teraFLOPS2 |

7,916 teraFLOPS2 |

|

INT8 Tensor Core |

3,958 TOPS2 |

3,026 TOPS2 |

7,916 TOPS2 |

|

GPU 内存 |

80GB |

80GB |

188GB |

|

GPU 内存带宽 |

3.35TB/s |

2TB/s |

7.8TB/s3 |

|

解码器 |

7 NVDEC 7 JPEG |

7 NVDEC 7 JPEG |

14 NVDEC 14 JPEG |

|

最大热设计功率 (TDP) |

高达 700W (可配置) |

300-350W (可配置) |

2x 350-400W (可配置) |

|

多实例 GPU |

高达 7 个 MIG,每个 10GB |

高达 7 个 MIG,每个 10GB |

高达 14 个 MIG,每个 12GB |

|

形态 |

SXM |

PCIe 双槽气冷 |

PCIe 双槽气冷 |

|

互联 |

NVLink: 900GB/s PCIe Gen5: 128GB/s |

NVLink: 600GB/s PCIe Gen5: 128GB/s |

NVLink: 600GB/s PCIe Gen5: 128GB/s |

|

服务器选项 |

NVIDIA HGX™ H100 伙伴和 NVIDIA 认证系统™,配备 4 或 8 个 GPU |

NVIDIA DGX™ H100 配备 8 个 GPU |

伙伴和 NVIDIA 认证系统,配备 1–8 个 GPU |

|

NVIDIA 企业附加组件 |

包含 |

包含 |

NVIDIA H100 Tensor Core GPU

H100 使用定制的 TSMC 4N 工艺制造,包含 800 亿个晶体管,适应 NVIDIA 的加速计算需求,H100 具有重大的进步,可以在数据中心规模上加速 AI、HPC、内存带宽、互联和通信。

第二代多实例 GPU (MIG)

Hopper 架构的第二代 MIG 支持在虚拟化环境中的多租户、多用户配置,安全地将 GPU 划分为隔离的、合适大小的实例,以最大化服务质量 (QoS) 并支持 7 倍更多的安全租户。

Transformer 引擎

Transformer 引擎使用软件和 Hopper Tensor Core 技术设计,加速基于世界上最重要的 AI 模型构建块——transformer 的模型训练。Hopper Tensor Core 可以应用混合 FP8 和 FP16 精度,以显著加速 transformers 的 AI 计算。

NVLink 交换系统

NVLink 交换系统可以在多个服务器之间扩展多 GPU 输入/输出 (IO),每个 GPU 的双向速度为 900GB/s,比 PCIe Gen5 的带宽高出 7 倍。该系统支持多达 256 个 H100 的集群,并提供比 NVIDIA Ampere 架构的 InfiniBand HDR 高 9 倍的带宽。

NVIDIA 机密计算

NVIDIA H100 为具有机密性和完整性的工作负载提供高性能的安全性。机密计算为正在使用的数据和应用提供基于硬件的保护。

DPX 指令

Hopper 的 DPX 指令可以将动态编程算法的加速提高到 CPU 的 40 倍,及比 NVIDIA Ampere 架构 GPU 提高 7 倍。这显著加快了疾病诊断、实时路由优化和图形分析的时间。

探索 NVIDIA Hopper 技术突破

在 GPT-3 上实现高达 4 倍更高的 AI 训练

如需了解更多有关 NVIDIA H100 Tensor Core GPU 的信息,请访问:

部署 H100 与 NVIDIA AI 平台

NVIDIA AI 是基于 NVIDIA H100 GPU 的端到端生产 AI 开放平台。它包括 NVIDIA 加速计算基础设施、用于基础设施优化和 AI 开发与部署的软件堆栈,以及加速上市时间的应用工作流。在 NVIDIA LaunchPad 上通过免费动手实验体验 NVIDIA AI 和 NVIDIA H100。